Salon Kraśnik: +48 81 825 97 22 sklep@beiks.pl Salon Warszawa: +48 22 891 13 73 wawa@beiks.pl

Sklep internetowy: +48 600 101 768 sklep@beiks.pl

Salon Kraśnik: +48 81 825 97 22 sklep@beiks.pl Salon Warszawa: +48 22 891 13 73 wawa@beiks.pl

Sklep internetowy: +48 600 101 768 sklep@beiks.pl

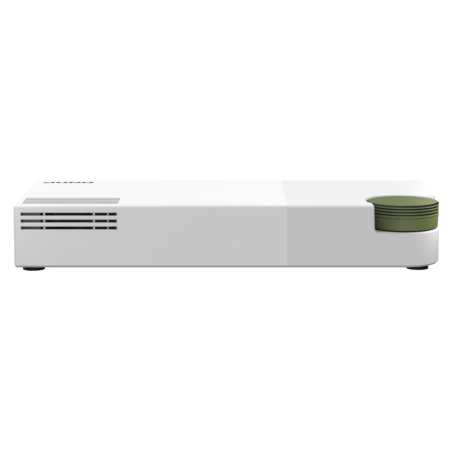

Serwery NAS

Serwery NAS ( Network Attached Storage) – urządzenie pamięci masowej podłączone do sieci, umożliwiające przechowywanie i uzyskiwanie dostępu do danych ze scentralizowanej lokalizacji przez upoważnionych użytkowników sieciowych oraz zróżnicowanych klientów. Systemy NAS są elastyczne, dzięki czemu wtedy, gdy potrzebna jest dodatkowa pamięć masowa, można ją dodać do tego, czym dysponuje się obecnie. System NAS przypomina posiadanie chmury prywatnej w biurze. Jest szybszy, tańszy i zapewnia wszytskie korzyści wynikające z chmury publicznej, dając przy tym pełną kontrolę. Serwery Nas są idealnym rozwiązaniem dla małych i średnich firm. Są proste w obsłudze, zapewniają łatwe tworzenie kopii zapasowych danych i ich nieprzerwaną dostępność, są dobre w centralizacji przechowywania danych w sposób bezpieczny i niezawodny, zapewniają niższy koszt.

System NAS zapewnia stałą dostępność danych, dzięki czemu pracownicy mogą współpracować, szybko reagować na potrzeby klientów i szybko śledzić sprzedaż lub inne kwestie, gdyż informacje znajdują się w jednym miejscu. Ponieważ system NAS działa jak prywatna chmura, dane mogą być dostępne zdalnie za pomocą połączenia sieciowego, co oznacza, że pracownicy mogą pracować w dowolnym miejscu i w dowolnym czasie.

5 products